OpenAI hat heute sein neuestes Sprachmodell vorgestellt: GPT-4.1. Das Update bringt eine Reihe bemerkenswerter Verbesserungen mit sich – insbesondere im Hinblick auf Genauigkeit, Geschwindigkeit und Multimodalität. Der folgende Beitrag gibt einen Überblick über die wichtigsten Neuerungen, technischen Details und zukünftige Einsatzmöglichkeiten.

GPT-4.1 basiert auf einem einheitlichen Modell

Eine der größten Änderungen: GPT-4.1 vereint die verschiedenen Modalitäten – Text, Bild, Audio und Code – in einem einzigen Modell. Während frühere Versionen wie GPT-4 zwischen Text-only und Multimodalität unterschieden, ermöglicht GPT-4.1 eine flüssige Interaktion über mehrere Eingabeformen hinweg. Das Modell kann Texte verstehen und generieren, Bilder analysieren, Audiodateien transkribieren und sogar komplexe Aufgaben im Programmierkontext bearbeiten – alles über eine zentrale API.

Für Entwicklerinnen und Anwenderinnen bedeutet das: keine Umwege mehr über separate Tools oder Modelle, sondern eine konsistente Schnittstelle für verschiedene Anwendungszwecke.

Verbesserte Intelligenz und Systemverhalten

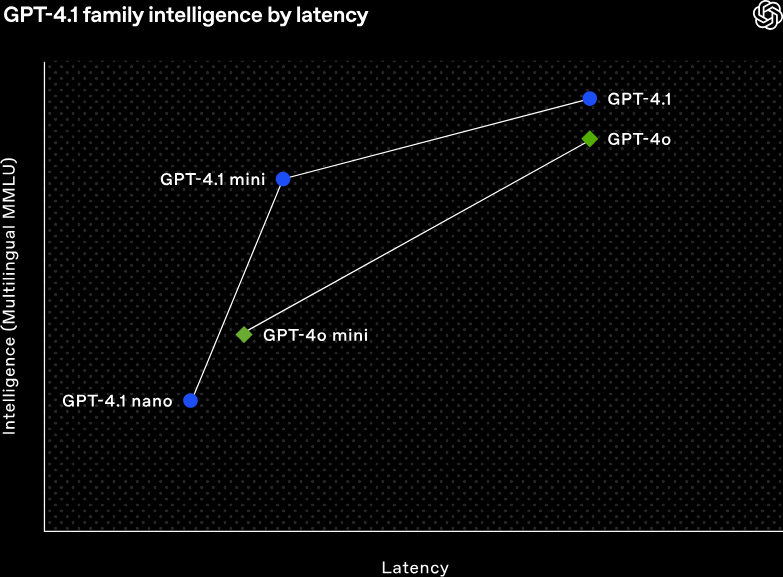

OpenAI gibt an, dass GPT-4.1 deutlich besser darin ist, komplexe Aufgaben korrekt zu lösen. In Benchmark-Tests wie dem MMLU (Massive Multitask Language Understanding) erreicht GPT-4.1 eine beeindruckende Punktzahl von 88,1 %, was auf dem Niveau von spezialisierten Expert*innen liegt. Zum Vergleich: GPT-4 kam hier noch auf 86,4 %.

Auch das sogenannte „Systemverhalten“ – also wie sich das Modell auf Anweisungen und Vorgaben einstellt – wurde überarbeitet. In der neuen Version lassen sich Rollen, Regeln und Stile stabiler und konsistenter definieren. Das Modell bleibt dabei über längere Unterhaltungen hinweg „in Charakter“ und folgt präziser den gewählten Anweisungen. Das ist vor allem für den Einsatz in Chatbots, Assistenzsystemen oder beim automatisierten Schreiben relevant.

Größeres Kontextfenster: 128.000 Tokens

Ein weiteres technisches Upgrade betrifft das Kontextfenster – also die Menge an Information, die das Modell gleichzeitig verarbeiten kann. GPT-4.1 unterstützt nun bis zu 128.000 Tokens, was in etwa 300 Seiten Text entspricht. Dadurch kann das Modell sehr lange Dokumente erfassen, über viele Abschnitte hinweg konsistent bleiben und Zusammenhänge erkennen, die bisher verloren gingen.

Gerade für juristische, wissenschaftliche oder redaktionelle Anwendungen dürfte das eine spürbare Verbesserung bringen.

Neue Tools: Code-Interpreter, Vision, Web-Browsing

GPT-4.1 integriert nun von Haus aus mehrere Werkzeuge, die bislang nur in Spezialversionen verfügbar waren:

- Code-Interpreter: Auch als „Advanced Data Analysis“ bekannt, erlaubt dieses Tool die Analyse komplexer Datensätze, das Erstellen von Diagrammen oder das Lösen mathematischer Aufgaben.

- Vision: Das Modell kann Bilder interpretieren, beschreiben oder inhaltlich analysieren – etwa für Barrierefreiheit oder kreative Anwendungen.

- Web Browsing: GPT-4.1 kann auf aktuelle Inhalte im Internet zugreifen, etwa um Fakten zu prüfen oder nach neuen Informationen zu suchen.

Alle Tools sind nahtlos integriert und können gleichzeitig verwendet werden. Damit wird GPT-4.1 zu einem echten Allround-Werkzeug für viele Berufsgruppen.

GPT-4.1 ist im ChatGPT Pro-Abo enthalten

Das neue Modell ist zunächst ausschließlich im ChatGPT Pro-Abo verfügbar. Dieses kostet derzeit 20 US-Dollar pro Monat. Wer das Abo nutzt, bekommt automatisch Zugriff auf GPT-4.1, inklusive der neuen Tools und Features.

Laut OpenAI wird GPT-4.1 das bisherige GPT-4-Modell in ChatGPT vollständig ersetzen. Für Unternehmen oder Entwickler*innen, die über die API arbeiten, wird GPT-4.1 ebenfalls bald bereitgestellt – ein genaues Datum steht allerdings noch aus.

Ausblick: Sicherheit und Feedbackkultur

OpenAI betont, dass GPT-4.1 nicht nur leistungsfähiger, sondern auch sicherer sein soll. Das Modell wurde mit mehr Feedback-Daten trainiert, unter anderem durch das OpenAI-eigene „Preparedness Framework“. Es soll besser darin sein, schädliche Inhalte zu erkennen und zu vermeiden, ohne in seiner Funktionalität eingeschränkt zu sein.

Gleichzeitig ruft OpenAI weiterhin zur Partizipation auf: Nutzer*innen sollen Rückmeldungen geben, um das Modell im Sinne aller sicherer und fairer zu gestalten.

GPT-4.1 markiert einen deutlichen Schritt nach vorne in der KI-Entwicklung. Mit einem vereinheitlichten Modell, besseren Antwortfähigkeiten, größerem Kontextverständnis und integrierten Tools bringt es mehr Flexibilität und Präzision in verschiedenste Arbeitsbereiche. Besonders spannend: Die Multimodalität und die Möglichkeit, auf aktuelle Webinhalte zuzugreifen – das eröffnet neue Wege im Umgang mit Informationen.

Member Diskussion