Einführung in Qwen3

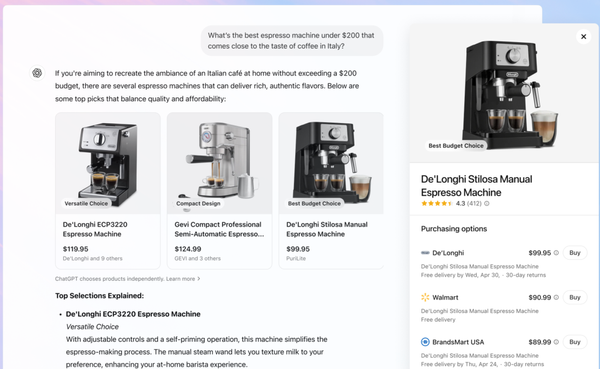

Qwen3 umfasst eine Reihe leistungsstarker Modelle, darunter die Flaggschiffe Qwen3-235B-A22B und Qwen3-30B-A3B. Diese Modelle überzeugen in Benchmarks zu Programmierung, Mathematik und allgemeinen Fähigkeiten und treten in direkte Konkurrenz mit Top-Modellen wie DeepSeek-R1, Grok-3 und Gemini-2.5-Pro.

Auch sollen kleinere Modelle wie Qwen3-4B eine Performance erreichen, die vergleichbar mit deutlich größeren Vorgängern sein sollen.

Breites Modellangebot und Open-Source-Verfügbarkeit

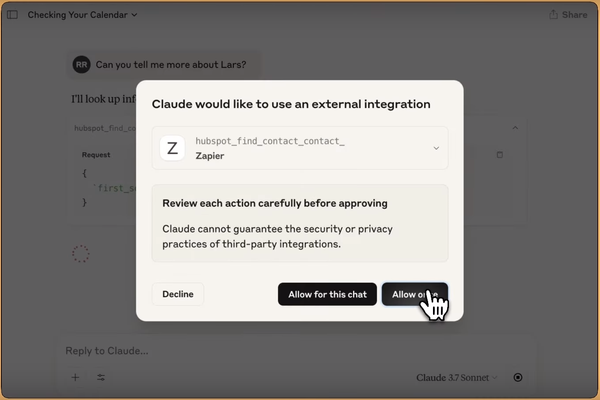

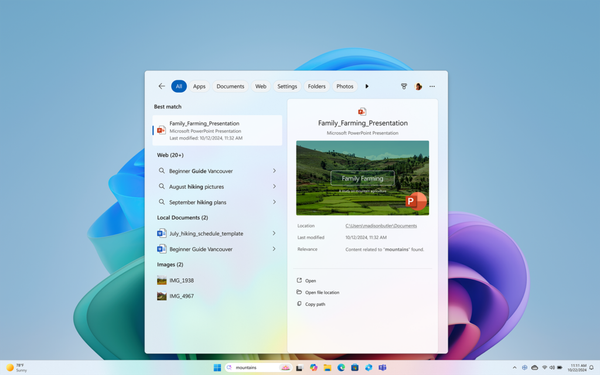

Qwen3 bietet sowohl große MoE-Modelle (Mixture of Experts) als auch sechs kompakte, dichte Modelle. Diese Modelle sind Open Source unter der Apache 2.0 Lizenz verfügbar und können auf Plattformen wie Hugging Face, ModelScope und Kaggle heruntergeladen werden.

Für die Integration in eigene Systeme empfehlen die Entwickler moderne Frameworks wie SGLang, vLLM, sowie lokale Tools wie Ollama und LMStudio. Damit wird der Einsatz sowohl in Forschung als auch in produktiven Anwendungen erleichtert.

Innovative Denkmodi: Flexibel je nach Aufgabe

Eine zentrale Neuerung von Qwen3 ist die Einführung von zwei Denkmodi:

- Thinking Mode: Das Modell nimmt sich Zeit für eine schrittweise Problemlösung, ideal für komplexe Aufgaben.

- Non-Thinking Mode: Antworten werden nahezu in Echtzeit generiert, perfekt für einfache Fragen.

Diese hybride Herangehensweise ermöglicht eine flexible Anpassung an die jeweilige Aufgabenstellung und eine optimierte Nutzung von Rechenressourcen.

Umfassende Mehrsprachigkeit

Mit Unterstützung für 119 Sprachen und Dialekte baut Qwen3 seine internationale Einsatzfähigkeit massiv aus. Neben weit verbreiteten Sprachen wie Englisch, Deutsch und Chinesisch werden auch kleinere Sprachgemeinschaften wie Asturisch, Maithili oder Faroese berücksichtigt. Damit eignet sich Qwen3 für globale Anwendungen.

Verbesserte Fähigkeiten in Programmierung und Agentik

Ein weiterer Fokus bei der Entwicklung lag auf den Agentic-Fähigkeiten und der Programmierkompetenz. Mit speziellen Optimierungen für Mathematik und Codeverarbeitung richtet sich Qwen3 an Entwickler und Forschungseinrichtungen, die auf der Suche nach zuverlässigen KI-basierten Problemlösungen sind.

Die Trainingsdatenmenge wurde im Vergleich zum Vorgänger Qwen2.5 fast verdoppelt. Insgesamt basieren die Modelle auf 36 Billionen Token aus unterschiedlichsten Quellen, darunter strukturierte Dokumente und speziell erzeugte synthetische Daten für Mathematik und Programmierung.

Mit offenen Gewichten, flexiblen Denkmodi, umfangreicher Mehrsprachigkeit und starker Performance in spezialisierten Aufgabenfeldern richtet sich das Modell an eine breite Nutzerbasis von Forschung bis hin zu Industrieanwendungen.

Member Diskussion